6 curiosidades sobre as buscas do Google que você provavelmente não sabia

Mesmo com quase 25 anos de existência, o buscador do Google ainda é um mistério para muita gente, e não é para menos, afinal ele está em constante mutação desde a sua criação, em 1997. São várias pequenas atualizações mensais e tantas outras maiores que regularmente transformam a pesquisa na internet de forma profunda.

Do início do mecanismo de busca até os dias atuais, a companhia expandiu seu modelo de negócios para abarcar um site de vídeos, um sistema operacional para celulares, uma rede social, uma suíte imensa de aplicativos, um sistema de venda de publicidade e um laboratório de criação de inovações tecnológicas. Embora tenha feito todo esse percurso, jamais deixou de focar no que a tornou conhecida: o buscador.

O Canaltech teve a oportunidade de conversar exclusividade com Danny Sullivan, executivo do Google e um dos maiores especialistas em ferramentas de pesquisa do mundo. Além de traçar um panorama do sistema de buscas, Sullivan apresentou alguns dados curiosos sobre a rotina da companhia, separados e listados a seguir:

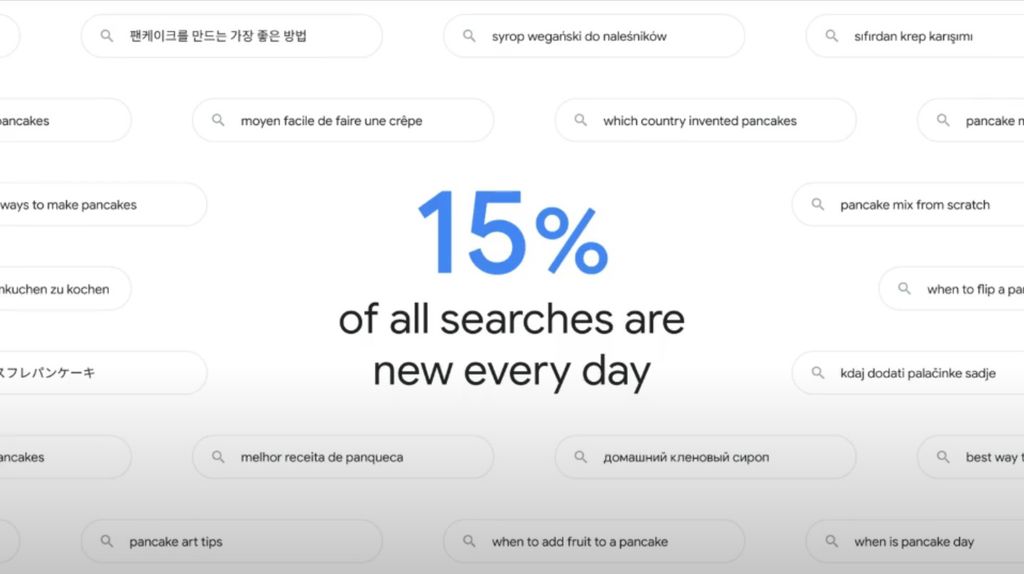

1. 15% de novos termos todos os dias

Todos os dias, o algoritmo do Google se depara com palavras-chave novas: 15% das pesquisas diárias são enquadradas desta forma. Isso não significa que sejam palavras exclusivas ou expressões inéditas necessariamente, mas combinações que nunca haviam sido usadas antes.

Por exemplo: imagine que hoje tem jogo do Glasgow Rangers, da Escócia, contra a Chapecoense, por um torneio amistoso. Provavelmente esses times nunca se enfrentaram antes e as pessoas vão querer saber o dia, a hora, o local e outras informações sobre a partida. Os sistemas então precisam processar isso e trazer a resposta de forma rápida e precisa, mesmo que jamais tenham lidado com isso antes.

Isso vale também para expressões de outros idiomas que eventualmente tornam-se populares de forma universal ou para nomes próprios de empresas, como Tiktok, que não era uma palavra procurada há dez anos.

2. 12 viagens à Lua em pesquisas impressas

A pesquisa precisa se adaptar todos os dias aos trilhões de sites da web já existentes e aos milhares que surgem eventualmente. Os usuários não querem saber apenas dos mesmos sites, razão pela qual o algoritmo precisa estar em constante evolução para entregar experiências completas. Isso é feito por intermédio de ferramentas chamadas crawlers, robôs que identificam novas páginas e as indexam nas buscas.

Hoje, apenas a inexação dos sites ocupa mais de 100 milhões de GB. Vale lembrar que o Google não hospeda os conteúdos das páginas, então esse volume imenso apenas diz respeito às referências para as quais o mecanismo de busca aponta. São tantas páginas de resultados que se elas fossem todas impressas e organizadas lado a lado como um livro, daria para fazer 12 viagens à Lua.

3. Testes, testes e mais testes

Toda grande companhia tem por hábito realizar testes antes de disponibilizar algo ao consumidor. O Google faz o mesmo com a busca: antes de liberar para todos, são conduzidos experimentos internos, com avaliadores ou grupos pequenos de usuários, no intuito de mensurar os resultados. Quando algo dá certo e traz melhorias concretas, a empresa solta como uma atualização. Se a resposta é negativa, aquela proposta retorna para ser melhor trabalhada.

Por ano, o Google realiza: mais de 610 mil testes de qualidade, mais de 10 mil experimentos de tráfego, cerca de 60 mil experimentos comparativos e algo próxima de 5 mil atualizações do algoritmo. Os testes side-by-side são um dos mais interessantes, já que há um comparativo entre pessoas com as mesmas características para ver qual resultado tem melhor performance.

4. Fortes sinais (da busca)

Alguns gurus do Search Engine Optimization (SEO) costumam se gabar por conhecer todas as regras de indexação do Google, mas isso é uma grande mentira. Para analisar uma página, o algoritmo considera mais de 200 sinais, ou seja, critérios para identificar se aquela página corresponde ou não aos anseios. Alguns desses sinais são bem óbvios, como a necessidade de ter um conteúdo de qualidade e inédito, mas outros somente fazem sentido para as máquinas.

É impossível saber quais são todos os critérios empregados pelo sistema na hora de ranquear um site, porque muitos deles sequer são compreensíveis por seres humanos. Além disso, tudo é analisado de forma simultânea e em conjunto, o que, mais uma vez, torna uma análise feita por reles mortais algo improvável.

Mesmo assim, há um conjunto de práticas mais generalistas que dependem exclusivamente dos produtores de conteúdo e criadores de site. Essas boas práticas devem ser seguidas e ajudam a ganhar muitos pontos com o tio Google na hora do ranqueamento.

5. Avaliadores em todo o planeta

O Google conta com mais de 10 mil avaliadores humanos que analisam os resultados das buscas e trazem sugestões para aprimorar as pesquisas. Segundo Danny Sullivan, essas pessoas estão espalhadas por vários países e são falantes de inúmeros idiomas, justamente no intuito de atender ao maior número possível de usuários, das cidades mais populosas às regiões mais remotas.

Essas pessoas não têm o poder para intervir no ranqueamento de páginas de forma individualizada, pois isto poderia gerar uma avaliação subjetiva e favorecimento. São feitas apenas análises se o conteúdo da página está ou não relacionado aos termos da busca: o relatório é enviado para os sistemas automatizados, que decidirá o que fazer.

Para balizar o trabalho, eles seguem um documento com diretrizes gerais com cerca de 200 páginas, o que deixa todos em sintonia para executar o trabalho de forma semelhante em cada localidade.

6. Luta contra o spam

Não é só no seu e-mail que você está sujeito a spam: a irritante prática também se estende à web, especificamente em páginas. O filtro do buscador do Google detecta e barra 40 bilhões de páginas com essa prática diariamente. Assim como nos filtros do correio eletrônico, eventualmente uma ou outra página pode driblar o sistema e chegar ao usuário, o que é logo corrigido assim que detectado.

Esse tipo de página tem propósitos diversos: desde ganhar dinheiro com propagandas sem oferecer nada em troca, roubo de informações pessoais, disseminação de malware até tentativas de golpe. Para identificar isso, as soluções de aprendizado de máquina são combinadas com a capacidade de aplicação manual de critérios pelos avaliadores.

*Com informações do Canaltech.